Saloperie de bienvenue

Bienvenue dans cette saloperie de wiki. Évidemment, ce wiki est un projet collaboratif et peut contenir des erreurs. N'hésitez pas à nous informer des fautes que vous pouvez voir, mais aussi des ajouts que vous souhaiteriez voir apparaître.

Si vous souhaitez ajouter un article par vous-même et donc devenir comme nous des salops de collaborateurs, vous pouvez nous envoyer un markdown ou un txt sur le sujet de votre choix et il sera ajouté sous le pseudo que vous souhaitez. Cependant, pour que le wiki garde une certaine qualité, il sera soumis à une saloperie de test pour vérifier son bon fonctionnement.

Pour cela une seule adresse wiki@salo.pe.

Merci pour la lecture et profitez à fond de nos saloperies d'articles.

Markdown

Par ce salop d'Oreo

Le markdown

Le markdown est un langage de balisage (Markup Language) tout comme le HTML (HyperText Markup Language), le XML ou le LaTeX. Dans ces différents langages, des balises permettent dce délimiter des séquences de caractères afin de traiter le texte d'une manière particulière lors de son affichage.

L'intérêt principal du markdown est sa simplicité de lecture et d'écriture permettant une rédaction rapide et fluide tout en mettant en place une structure claire dans le document en vue de sa relecture.

Le Markdown est souvent utilisé dans les blogs, les messageries instantanées, les forums et même (attention, suprise) dans la création de wiki (oui ce wiki est écrit en Markdown) du fait de la rapidité de son apprentissage.

Syntax

Bold and italic

*italic text* italic text

_italic text_ italic text

**bold text** bold text

__bold text__ bold text

***italic and bold text*** italic and bold text

___italic and bold text___ italic and bold text

Crossed out text

~~cross out text~~ cross out text

Titles

# Title 1

## Title 2

### Title 3

#### Title 4

##### Title 5

Paragraph

To insert a new paragraph just put a new ligne.

To insert a end of line put two spaces or a \.

Quote

> some text

> continue the text

> an other text zone

some text continue the text

an other text zone

List

You can use the plus sign, the dash or an asterisk as follows:

* l1

* l2

* l3

- l1

- l2

- l3

Code

To print code you can use backtick:

`code`

You can also use three backticks to print a block of code and add the programing language to print syntax in color.

```html

<body>

TOTO

</body>

```.

<body>

TOTO

</body>

Hyperlink

To display a clickable hyperlink use < hyperlink >.

To display an hyperlink not clickable use ` hyperlink `.

To give an alternative name to an hyperlink just add [Name] in front of your link.

Images

alternative text image link

v v

Tables

| cell title1 | cell title 2|

|--------|--------|

| A | B |

| C | D |

| cell title1 | cell title 2 |

|---|---|

| A | B |

| C | D |

Footnotes

In the text I place [^1] a footnotes \

[^1]: this is a footnote

In the text I place 1 a footnotes

this is a footnote

LaTeX

Par ces salops de Kuro et FanfanlaTulipe

Alors là, on va aborder une belle saloperie.

Pandoc

pandoc est une bibliothèque Haskell et un convertisseur pour transformer un format de document en un autre (voir le site ci-dessous pour voir les formats supportés).

Nous aborderons ici la converstion d'un mélange de markdown, LaTeX et HTML en pdf.

Nous allons faire un makefile pour transformer notre document source (ici saloperie.md) en LaTeX compilé en pdf. PENSEZ A REMPLACER LES ESPACES PAR DES TABULATIONS POUR QUE LE MAKEFILE SOIT VALIDE

makefile :

# A perfect makefile to compile notion.so exported markdown

CC=pandoc

C_ARGS=-f markdown-implicit_figures

# Definition des differents pdfs pouvant être compilés

# saloperie.pdf: header.md_ saloperie_de_markdown.md_

# saloperie.pdf est le nom du pdf généré

# header.md_ saloperie_de_markdown.md_ est la liste des md devant être mis dans le pdf

# dans l'ordre avec un _ en fin de nom

saloperie.pdf: header.md_ saloperie.md_

saloperie2.pdf: header.md_ saloperie2.md_

# Merge les dépendences en un fichier et le compile

%.pdf:

cat $^ > $@.tmpdf.md

$(CC) $(C_ARGS) -o $@ $@.tmpdf.md

# Génère les markdown pratiques pour êtres compilés en Latex

%.md_: %.md

@# Copie le fichier markdown dans un nouveau fichier avec _ en début et sans le .md

cp $< $@

@# Remplace les lignes ne contenant que `\\` par des `\newpage`

sed -i 's/^\\\\$$/\\newpage/' $@

@# Retire les commentaires `Untitled` des images (quand export depuis Notion)

sed -i 's/!\[Untitled\]/![]/' $@

@# remplace les %20 dans le fichier par des underscores (pour retirer les espaces des noms de fichiers qui cassent pandoc)

sed -i 's/%20/_/g' $@

@# centre les images

sed -i 's/^\!\[.*\]\(.*\)$$/\\centering\n\n&\n\n\\raggedright/g' $@

# Création du fichier header en modifiant les occurences de `$title` et `$authors` par les contenus des fichiers correspondants

header.md_: header.md title authors

@# Copie le fichier header.md dans un fichier _header

cp $< $@

@# Remplace `$title` par le contenu du fichier title

sed -i 's/$$title/'"$$(cat title)"'/' $@

@# Remplace `$authors` par le contenu du fichier title

sed -i 's/$$authors/'"$$(cat authors)"'/' $@

# Crée un fichier de titre basique si il n'existe pas

title:

cat << "EOF" > $@

Saloperie de pdf

EOF

sed -i 's/\\/\\\\/g' $@

# Crée un fichier authors basique si il n'existe pas

authors:

cat << "EOF" > $@

Un salaud d'anonyme\\Saloperie de Wiki

EOF

sed -i 's/\\/\\\\/g' $@

# Retire les espaces des noms de fichiers

# A lancer lors de l'export avant la première compilation

remove_space_in_files_names:

# Retire les espaces des dossiers

@find . -depth -type d -name "* *" -print -exec bash -c 'mv "$$0" "$${0// /_}"' {} \;

# Retire les espaces des fichiers

@find . -depth -type f -name "* *" -print -exec bash -c 'mv "$$0" "$${0// /_}"' {} \;

clean:

${RM} *.tmpdf.md

${RM} *.md_

${RM} *.pdf

.PHONY: all clean remove_space_in_files_names

.ONESHELL:

header.md :

---

numbersections: true

geometry: margin=3cm

header-includes:

- \usepackage{graphicx}

- \usepackage[ddmmyyyy]{datetime}

- \usepackage{fvextra}

- \DefineVerbatimEnvironment{Highlighting}{Verbatim}{breaklines,commandchars=\\\{\}}

---

<!--

graphicx : Permet de faire une image en latex sans forcement avoir une image en markdown ensuite

datetime : Permet de changer le format de date utilisé

fvextra et DefineVerbatimEnvironment : Permet un retour a la ligne automatique avec un `\` a la fin des lignes de code sortant de la page

-->

\begin{titlepage}

\centering

\vspace*{0.05cm}

\rule{\linewidth}{0.1 mm} \\[0.4 cm]

{ \huge \bfseries $title}\\

\rule{\linewidth}{0.1 mm} \\[1 cm]

\begin{minipage}{0.7\textwidth}

\begin{center} \large

\textbf{$authors}

\end{center}

\end{minipage}~

\begin{minipage}{0.7\textwidth}

\end{minipage}\\[3 cm]

\begin{figure}[h]

\centering

\includegraphics[width=5cm]{logo-saloperie.png}%

\end{figure}

\begin{center}

\today

\end{center}

\end{titlepage}

\newpage

\renewcommand{\contentsname}{Sommaire}

\tableofcontents

\newpage

Ce header nécessite d'avoir une image logo-saloperie.png à coté du Makefile

Pour compiler le fichier :

make

# ou

make saloperie.pdf

make clean # supprimer les fichiers générés et les fichiers temporaires

Pour encore un peu plus d'automatisation, vous pouvez placer ce Makefile, le fichier header.md et l'image logo-saloperie.png dans un dossier précis (ici ce sera ~/Desktop/pdf) et ajouter la fonction suivante dans votre .bashrc (ou tout autre fichier de configuration de shell que vous utilisez)

function pdf_makefile() {

cp ~/Desktop/pdf/Makefile ~/Desktop/pdf/logo.png ~/Desktop/pdf/header.md .

echo -n "$1: _header" >> Makefile

shift

for i in $@; do

echo -n " _$(echo $i | awk -F '.md$' '{ print $1 }')" >> Makefile

done

echo "" >> Makefile

}

Ainsi, lorsque vous souhaitez compiler un nouveau markdown, vous pouvez faire pdf_makefile pdf.pdf premier_markdown.md deuxieme_markdown.md et vous obtiendrez le makefile adapté avec la règle pour créer le pdf pdf.pdf en utilisant header.md comme header et avec premier_markdown.md et deuxieme_markdown.md comme contenu.

Gantt

Pour inclure des Gantt LaTeX dans votre pdf, vous pouvez ajouter l'inclusion suivante dans le fichier header.md

- \usepackage{pgfgantt}

Intégrez et utilisez ensuite les commandes LaTeX suivantes pour créer votre diagramme de Gantt

gantt.md :

<!--

================================================================================

COMMANDS DEFINITION

Available commands:

- \begin{coolGantChart}{start}{end}

Create a new Gantt from start to end indexes.

Thoses indexes are used to generate the gantt bars afterwards

- \end{coolGantChart}

End the gantt chart

- \gantttitle and \gantttitlelist

See Titles section in [pgfgantt documentation](https://texdoc.org/serve/pgfgantt.pdf/0)

- \coolNewGroup{Group title}

Create a group title for the following gantt bars

- \definecolor{actual}{RGB}{68,114,196}

Defines the `actual` color to RGB(68, 114, 196).

The `actual` color is used by default for the coolNewBar command

- \coolNewBar[color]{Bar title}{start_index}{end_index}

Create a gantt bar from start_index to end_index

Color defaults to `actual`

- \coolNewLink[line_count]{from}{to}

Create a link from the `from` bar to the `to` bar

The first bar created in the chart is indexed 0 and it increments for each bar created.

`line_count` correspond to the how much lines are between from and to to make the arrow turns at the right places

- \coolNewRevertLink[1]{1}{2}

Same as \coolNewLink but the turns are centered the opposite way (try it to understand fully)

Are are some nice colors to use for the bars

\definecolor{actual}{RGB}{68,114,196} % Blue

\definecolor{actual}{RGB}{112,173,71} % Light green

\definecolor{actual}{RGB}{255,217,102} % Yellow

\definecolor{actual}{RGB}{255,75,75} % Light red

\definecolor{actual}{RGB}{0,188,208} % Cyan

\definecolor{actual}{RGB}{237,125,49} % Orange

\definecolor{actual}{RGB}{112,48,160} % Purple

================================================================================

-->

\newcounter{test}

\newenvironment{coolGantChart}[2]{

\begin{ganttchart}[

x unit=0.50cm,

group left shift=0,

group top shift=0.4,

group right shift=0,

group height=0.7,

bar height=.5,

group peaks height=.0,

group peaks width=.0,

y unit chart=0.5cm,

y unit title=0.5cm,

title height=0.8

]{#1}{#2}

\setcounter{test}{0}

}{

\end{ganttchart}

}

\makeatletter

\newcommand\removeSpecialCharacters[1]{

\begingroup

\let\c\relax

\renewcommand\add@accent[2]{##2}

#1

\endgroup

}

\makeatother

\newcommand\coolNewBar[4][actual]{

\ganttbar[bar/.append style={fill=#1},name=\thetest]{#2}{#3}{#4}

\stepcounter{test}

}

\newcommand\coolNewGroup[1]{%

\ganttgroup[group/.append style={draw=black}]{#1}{-100}{-100}

}

\newcommand\coolNewLink[3][1]{

\ganttlink[link mid=(1 - 1/(2*#1))]{#2}{#3}

}

\newcommand\coolNewRevertLink[3][1]{

\ganttlink[link mid=(1/(2*#1))]{#2}{#3}

}

<!--

================================================================================

EXAMPLE GANT

================================================================================

-->

\begin{coolGantChart}{1}{36}

\gantttitle{1ère année}{12}\gantttitle{2ème année}{12}\gantttitle{3ème année}{12}\\

\gantttitlelist{1,...,36}{1} \\

\definecolor{actual}{RGB}{68,114,196}

\coolNewGroup{Groupe 1}{1}{36}\\

\coolNewBar{Barre 1}{1}{36}\\

\coolNewBar{Barre 2}{1}{6}\\

\coolNewBar{Barre 3}{7}{13}\\

\coolNewBar{Barre 4}{7}{11}\\

\coolNewLink[1]{1}{2}

\definecolor{actual}{RGB}{112,173,71}

\coolNewGroup{Groupe 2}{1}{12}\\

\coolNewBar{Barre 5}{1}{2}\\

\coolNewBar{Barre 6}{3}{7}\\

\coolNewRevertLink[2]{1}{3}

\coolNewLink[1]{4}{5}

\definecolor{actual}{RGB}{255,217,102}

\coolNewGroup{Groupe 3}{8}{29} \\

\coolNewBar{Barre 7}{12}{15} \\

\coolNewBar{Barre 8}{8}{15}\\

\coolNewBar{Barre 9}{16}{24} \\

\coolNewBar{Barre 10}{23}{29} \\

\coolNewLink[3]{3}{6}

\definecolor{actual}{RGB}{255,75,75}

\coolNewGroup{Groupe 3}{1}{24}l\\

\coolNewBar{Barre 11}{1}{3}

\addtocounter{test}{-1}

\coolNewBar{}{13}{18}\\

\coolNewBar{Barre 12}{3}{7}\\

\coolNewBar{Barre 13}{7}{24}\\

\coolNewBar{Barre 14}{1}{24}\\

\coolNewBar{Barre 15}{5}{11}\\

\coolNewRevertLink[14]{1}{12}

\definecolor{actual}{RGB}{237,125,49}

\coolNewGroup{Groupe 4}{1}{24}\\

\coolNewBar{Barre 16}{1}{8}\\

\coolNewBar{Barre 17}{13}{20}\\

\coolNewBar{Barre 18}{13}{18}\\

\coolNewLink{5}{16}

\coolNewLink[1]{3}{16}

\coolNewLink[1]{3}{17}

\definecolor{actual}{RGB}{112,48,160}

\coolNewGroup{Groupe 5}{1}{16}\\

\coolNewBar{Barre 19}{1}{6}\\

\coolNewBar{Barre 20}{3}{7}\\

\coolNewBar{Barre 21}{8}{10}\\

\coolNewBar{Barre 22}{11}{16}\\

\coolNewLink[2]{18}{20}

\coolNewLink[1]{20}{21}

\coolNewLink[2]{6}{8}

\coolNewLink[1]{7}{8}

\definecolor{actual}{RGB}{0,188,208}

\coolNewGroup{Grouope 6}{1}{13}\\

\coolNewBar{Barre 23}{1}{7}\\

\coolNewBar{Barre 24}{8}{13}\\

\coolNewLink[1]{22}{23}

\end{coolGantChart}

Slides

Contrairement aux autres articles sur le LaTeX qui utilisent pandoc et permettent donc de mélanger le LaTeX et le Markdown, nous utiliserons ici latexmk pour compiler le document.

slides.tex :

%\documentclass[handout, 11pt,a4paper,final,aspect ratio=169]{beamer} % This one is for printing

\documentclass[11pt,a4paper,final,aspect ratio=169]{beamer} % This one is for presenting (with \pause)

% See the following links to choose a theme and color

% http://mcclinews.free.fr/latex/beamergalerie/completsgalerie.html

% https://deic.uab.cat/~iblanes/beamer_gallery/index_by_theme_and_color.html

\usetheme{metropolis}

%\usecolortheme{seagull}

% Prevent navigation buttons on the slide

\beamertemplatenavigationsymbolempty

% Make sure table of content are numbered

\setbeamertemplate{section in toc}[sections numbered]

\setbeamertemplate{subsection in toc}[subsections numbered]

\usepackage[utf8]{inputenc}

\usepackage[french]{babel}

\usepackage{enumitem}

\setlist[description]{style=nextline} % Specific for some types of lists

\setlist[itemize]{label=\textbullet} % Specific for some types of lists

\newcommand\tab[1][4mm]{\hspace*{#1}}

% Add a slide when section changes

\AtBeginSection[]{

\begin{frame}

\sectionpage

\end{frame}

\addtocounter{framenumber}{-1}

}

% Add a slide when subsection changes

\AtBeginSubsection[]{

\begin{frame}

\subsectionpage

\end{frame}

\addtocounter{framenumber}{-1}

}

\title{titre}

\subtitle{sous titre}

\author{Moi}

\date{\today}

\begin{document}

\begin{frame}

\vspace*{0.05cm}

{\Large \bfseries Titre \\[0.2cm]}{\large Sous titre}\\

{\usebeamercolor[fg]{alerted text}{\rule{\linewidth}{0.2mm}\\[0.4cm]}}

\textbf{auteur}\\{\today}

\begin{figure}[h]

\centering

\includegraphics[width=0.2\textwidth]{img/logo1.png}%

\tab[8mm]

\includegraphics[width=0.2\textwidth]{img/logo2.png}%

\tab[8mm]

\includegraphics[width=0.2\textwidth]{img/logo3.png}%

\end{figure}

\end{frame}

\begin{frame}

\tableofcontents

\end{frame}

\section{Définitions}

\begin{frame}{\secname}

\begin{description}

\item[Mot]{Définition}

\item[Mot 2]{Définition 2}

\end{description}

\end{frame}

\section{Partie 1.}

\subsection{Partie 1.1}

\begin{frame}{\secname ~--\subsecname}

Such slide\pause

Such animation

\end{frame}

\subsection{Partie 1.2}

\begin{frame}{\secname ~--\subsecname}

Such new slide\pause

Such new animation

\end{frame}

%\input{otherfile.tex}

\end{document}

La compilation se fait avec la commande latexmk -pdf slides.tex

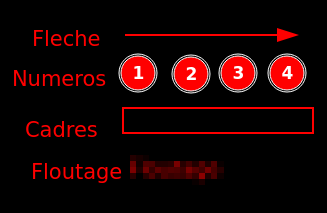

Flameshot

Par ce salop de Kuro

Vous devez faire une saloperie de tutoriel d'installation ? Vous êtes au bon endroit !!

Flameshot

Flameshot est un programme permettant de prendre des captures d'écran et d'y ajouter quelques précisions directement.

Il a été utilisé conjointement à Notion et à un Makefile pandoc afin de réaliser des tutoriels d'installation de différents systèmes et, entre autre, de certains tutos de ce wiki.

Installation

Pour installer flameshot, référez-vous au site de flameshot ou, sur Archlinux, utilisez simplement la commande pacman -S flameshot.

Utilisation

Pour utiliser flameshot, il vous faudra d'abord le lancer afin qu'il soit disponible en arrière plan.

Vous pourrez ensuite utiliser la commande flameshot gui pour voir apparaître les propositions pour faire le screenshot.

Vous pourrez alors ajouter des fioritures sur l'image résultante afin d'expliciter ce que vous souhaitez expliquer dans l'image en question.

Vous pouvez alors enregistrer sous le screenshot modifié ou bien tout simplement utiliser ctrl + c pour le copier et pouvoir ensuite le coller, par exemple sur Notion.

Pensez à configurer les raccourcis de flameshot afin de simplifier l'accès à ces fioritures.

Sous Windows

Flameshot remplace automatiquement la touche Imp. écran lorsqu'il est lancé. Pour lancer flameshot au démarrage faire Win + R puis taper shell:startup et enfin glisser un raccourci vers flameshot dans ce dossier. Les options de configuration sont disponibles en faisant un clic droit sur l'icône flameshot dans les tâches minimisées.

Un peu de scripting

Bien que flameshot soit un outil très pratique de base, quelques fonctionnalités manquaient afin de réellement industrialiser les screenshots. Nous avons donc fait le choix de faire un peu de bash pour les ajouter.

~/.local/bin/vmscreen

#!/bin/bash

function flameshot_save_result() {

val=$(flameshot gui -g)

echo $val | grep aborted || echo $val > /tmp/flameshot_vmscreen

}

[ $# -eq 0 ] && [ -e /tmp/flameshot_vmscreen ] && VMSCREEN_CONFIG=$(cat /tmp/flameshot_vmscreen)

flameshot_save_result &

if [ ! -z "$VMSCREEN_CONFIG" ] && [ "$VMSCREEN_CONFIG" != "screenshot aborted" ] ; then

sleep 0.1

xdotool mousemove --screen 0 $(cut -d' ' -f 3,4 <<< $VMSCREEN_CONFIG)

xdotool mousedown 1

xdotool mousemove_relative $(( $(cut -d' ' -f 1 <<< $VMSCREEN_CONFIG) - 1)) $(( $(cut -d' ' -f 2 <<< $VMSCREEN_CONFIG) - 1))

xdotool mouseup 1

fi

.config/i3/config sous i3, une autre manière d'ajouter des raccourcis sinon

bindsym $mod+p --release exec "~/.local/bin/vmscreen"

bindsym $mod+Shift+p --release exec "~/.local/bin/vmscreen new"

bindsym Print --release exec "flameshot gui"

Avec ce script et ces raccourcis, vous pouvez soit utiliser votre touche Capture d'écran et accéder à la capture d'écran, soit utiliser $mod+p et $mod+Shift+p pour utiliser les scripts.

- A la première utilisation,

$mod+psemblera lancer flameshot normalement. Cependant, la position de la zone de l'écran capturée est sauvegardée et la prochaine utilisation de$mod+psélectionnera directement la même zone de l'écran. Cela permet de sélectionner toujours la même zone d'un écran (par exemple l'emplacement d'une machine virtuelle sur l'écran) sans avoir à refaire la zone à chaque fois. $mod+Shift+ppermet de refaire une sélection de zéro qui sera enregistrée.

Attention !! Quitter la prise de screenshot avec échap gardera l'ancien paramétrage en mémoire et utiliser

flameshot guiou la toucheCapture d'écranne modifiera pas ce qui avait été enregistré.

Pare-feu et iptables

Par ce salop de FanfanlaTulipe

Nous aborderons ici le sujet des pare-feu, point cruciale dans la sécurité des serveurs et des réseaux.

Pare-feu

Un pare-feu permet de filtrer les flux réseaux sur une machine et de faire respecter la politique de sécurité du réseau. Nous distinguerons deux définitions du pare-feu :

- Pare-feu matériel : il s'agit d'un matériel réseau dont le but est de filtrer les flux réseaux le traversant. On peut par exemple citer les pare-feu Fortinet ou Palo Alto.

- Pare-feu logiciel : il s'agit d'une couche réseau qui va filtrer les flux réseaux déstinés à ou transitant par la machine. Là, on peut citer Windows Defender (pare-feu de Microsoft), iptables (pare-feu Linux) ou pf (pare-feu BDS).

La suite de ce guide parle des pare-feu logiciels. Nous désignemerons par "pare-feu" les pare-feu logiciels.

Le filtrage se fait selon plusieurs critères, par exemple :

- La source et la destination d'un paquet (IP, port, interface réseau)

- Les données transportées (taille, correspondance avec un motif)

On distingue deux types de pare-feu :

- Sans état (Stateless): un pare-feu sans état ne va pas faire la distinction entre un nouveau paquet et un paquet présent suite à une connexion. Par exemple, dans le cas d'un pare-feu sans état sur un serveur web, il faut autoriser les flux entrants à destination du port 80 ET les flux sortants à l'origine du port 80.

- A état (stateful): à l'inverse, un pare-feu avec état va pouvoir déterminer si un paquet est neuf ou s'il provient d'une connexion déjà établie. Dans notre exemple, il suffit d'autoriser les flux entrants à destination du port 80 et le pare-feu autorisera les paquets en réponse à la requète à sortir.

Les pare-feu sans état sont donc bien plus stricts et permettent un meilleur contrôle des flux, mais sont plus compliqués à maintenir et la probabilité de faire des erreurs est plus grande. A l'inverse, les pare-feu à état sont plus simples d'utilisation et plus adaptés aux protocoles dit 'connectés' comme TCP.

Iptables

Wiki Arch Linux

Wiki sur les pare-feu à état et exemple de configuration

Guide concernant les pare-feu de l'ANSSI

iptables est un outil en ligne de commande pour configurer le pare-feu du noyau Linux (le terme "iptables" est aussi utilisé pour désigner ce pare-feu). Ce pare-feu est configurable directement avec iptables ou avec des outils graphiques (nous y reviendrons plus bas).

Il faut noter qu'

iptablesest utilisé pour la pile IPv4, etip6tablespour la pile IPv6.

ATTENTION, si vous travaillez sur une machine distante, faire une erreur lors de la configuration du pare-feu peut couper votre connexion et rendre la machine injoignable !

Par défaut, iptables est un pare-feu sans état. Il est cependant possible de le transformer en pare-feu à état avec le module noyau conntrack. Nous utiliserons conntrack pour la suite de ce guide. De plus, il est important de savoir qu'iptables fonctionne selon le principe du first-match. Cela signifie que la première règle qui correspond au paquet sera la règle appliquée.

Rendre iptables stateful

On accepte tous les paquets provenant de connexions déjà établies :

iptables -A INPUT -m conntrack --ctstate RELATED,ESTABLISHED -j ACCEPT

iptables -A OUTPUT -m conntrack --ctstate RELATED,ESTABLISHED -j ACCEPT

Il est donc nécessaire d'appliquer ses règles en premier, pour appliquer la règle du first-match.

Ne pas couper la connexion actuel dans le cas d'une machine distante

iptables -A OUTPUT -p tcp --sport 22 -m conntrack --ctstate ESTABLISHED,RELATED -j ACCEPT

Règles par défaut

Sous Linux, il est conseillé de mettre par défaut les règles suivantes :

- DROP sur le traffic entrant (INPUT)

- DROP sur le traffic transité (FORWARD)

- ACCEPT sur le traffic sortant (OUTPUT)

iptables -P INPUT DROP

iptables -P FORWARD DROP

iptables -P OUTPUT ACCEPT

Dans la logique du first-match, ces règles doivent être appliqué en dernières.

Règles persistentes

Les règles iptables ne survivent pas à un redémarrage. Il est donc nécessaire de faire quelques manipulations pour leurs permettre d'être persistentes. Nous utiliserons 2 binaires :

iptables-savepour sauvegarder les règles iptables.iptables-restorepour rétablir les règles iptalbes.

Pour sauvegarder les règles actuellement en place :

sudo iptables-save -f /etc/iptables/iptables.rules

De plus il faut un service qui se lancera un démarrage pour rétablir les règles :

sudo vim /usr/lib/systemd/system/iptables.service

[Unit]

Description=IPv4 Packet Filtering Framework

Before=network-pre.target

Wants=network-pre.target

[Service]

Type=oneshot

ExecStart=/usr/sbin/iptables-restore /etc/iptables/iptables.rules

ExecReload=/usr/sbin/iptables-restore /etc/iptables/iptables.rules

ExecStop=/usr/sbin/iptables -F

RemainAfterExit=yes

[Install]

WantedBy=multi-user.target

Outils graphiques

Le tocage à la porte

Le port knocking (normalement je préfère les termes français mais là...) est une méthode pour mettre d'ouvrir un port sur un pare-feu normalement fermé. Le pare-feu va attendre des connexions à des endroits bien spécifiques, dans un ordre précis. L'intéret du port knocking est de rendre un service invisible à un scan de port.

Nous verrons ici comment l'implémenter avec iptables.

Je vous jure je vais le faire.

Source du wiki Arch Linux

Sécurité par l'obscurité

Le principe de la sécurité par l'obscurité repose sur la non-divulgation d'information pour assurer la sécurité d'une structure (dans le cas de la sécurité informatique). On peut par exemple citer le rot n dans la cryptographie.

La sécurité par l'obscurité est dangereuse car elle donne un faux sentiment de sécurité. En effet, si le secret est découvert, toutes les messages passés, présentes et futures sont vulnérables (dans le cas de la cryptographie).

La question est donc : "Est ce que le tocage à la porte est une sécurité par l'obscurité ?"

Le tocage à la porte ne remplace pas une authentification classique. Cela doit être une mesure complémentaire uniquement pour contrer les scans de port ou les attaques par force brute. Le tocage à la porte ne doit en aucun cas donner accès à des ressources sensibles sans une autre forme d'authentification. Enfin, pour répondre à la question, le tocage à la porte peut être vu comme une forme de mot de passe supplémentaire, mais qui est récupérable avec une attaque de l'homme du milieu (man-in-the-middle) par exemple.

SSH

Par ce salop de FanfanlaTulipe et corrigé par ce salop de fl0w5

Secure SHell est un protocole de communication sécurisé (couche 7) destiné à remplacer rlogin, telnet et rsh (des protocoles non sécurisés) fonctionnant sur le port 22 par défaut.

Le Secure SHell Daemon représente le serveur SSH sur lequel les clients se connectent.

Vu la simplicité du système, nous n'expliquerons pas ici le fonctionnement du démon, nous n'aborderons que son installation et sa configuration. Nous utiliserons également l'implémentation OpenSSH (maintenu par OpenBSD).

Installation

Notre exemple d'installation sera fait sur une machine Debian.

apt install openssh-server -y

systemctl enable ssh

systemctl start ssh

systemctl status ssh # On vérifie que le démon tourne

Génération des clés

Basé sur les recommandations de l'ANSSI

SSH utilise un système de clé asymétrique pour l'authentification. Il faut noter que dans la pratique, on renouvelle assez peu les clés, il faut donc les faire robustes.

- La taille minimale d'une clé RSA est 2048 bits.

- La taille minimale d'une clé ECDSA est de 256 bits.

- DSA ne doit pas être utilisé.

Pour générer un biclé, entrez une des deux commandes suivantes, en fonction de votre implémentation favorite :

ssh-keygen -t rsa -b 2048 <fichier de clé RSA> # RSA

ssh-keygen -t ecdsa -b 256 <fichier de clé ECDSA> # ESDSA

Ces fichiers sont à utiliser comme clé d'identification hôte (attribut HostKey dans sshd) ou utilisateur (IdentifyFile dans ssh).

ECDSA doit être préféré à RSA si les clients et les serveurs le supportent.

Gestion des clés

Une clé privée d'authentification utilisateur ne doit être lisible que de ce dernier et protégée par un mot de passe. Ce chiffrement permet de laisser suffisamment de temps aux équipes d'administration pour révoquer le biclé.

Une clé privée d'authentification hôte ne doit être lisible que par le service sshd, soit l'utilisateur root :

-rw------- root:root /etc/ssh/ssh_host_rsa_key

-rw------- root:root /etc/ssh/ssh_host_ecdsa_key

Le répertoire ~/.ssh/ et son contenu doivent être protégés.

Afin de vérifier les modes et le propriétaire des fichiers de l'utilisateur avant la connextion :

StrictModes yes # Normalement activé de base

Choix des algorithmes symétriques

Le canal de comminication entre le client et le serveur est chiffré avec un algorithme symétrique. Dans /etc/ssh/sshd_config :

Ciphers aes256-ctr,aes192-ctr,aes128-ctr

# OpenSSH > 6.3

MACs hmac-sha2-512-etm@openssh.com,hmac-sha2-256-etm@openssh.com

# Anciennes versions

MACs hmac-sha2-512,hmac-sha2-265,hmac-sha1

Authentification

L'authentification d'un utilisateur doit se faire avec l'une des implémentations suivantes, dans l'ordre de préférence :

- ECDSA

- RSA

- tickets Kerberos

- PAM

- mot de passe vis-à-vis d'une base de données

Il faut savoir que le fichier authorized_keys, qui stocke normalement les clés publiques des utilisateurs déjà authentifiés, permet de configurer les accès d'un serveur.

# La clé n'autorise l'accès que si le client provient du réseau 192.168.1.0/24.

from="192.168.1.*" ssh-ecdsa AAAA...

# La clé autorise l'accès pour un client venant du domaine *.salo.pe sauf pour *.belle.salo.pe

from="!*.belle.salo.pe, *.salo.pe" ssh-rsa AAAA...

# Bloque l'usage de l'agent forwarding pour cette clé

no-agent-forwarding ssh-ecdsa AAAA...

Imputabilité

L'imputabilité des accès est nécessaire pour la traçabilité. Autrement dit, chaque utilisateur doit avoir son propre compte. De plus, le compte root ne doit pas être accessible :

PermitRootLogin no

Configuration sécurisée

/etc/ssh/ssh_config est le fichier de configuration du client.

# Il faut s'assurer de l'authenticité du serveur.

StrictHostKeyChecking ask

/etc/ssh/sshd_config est le fichier de configuration du serveur OpenSSH.

# SSH existe en 2 versions, SSHv1 et SSHv2. SSHv1 présentant des problèmes de sécurité,

# nous forcerons l'utilisation du protocol v2.

Protocol 2

# Si le serveur SSH est exposé à un réseau non maitrisé, il est recommandé de lui

# mettre un port d'écoute différent de celui par défaut (22). Il est conseillé

# d'utiliser un port inférieur à 1024 afin d'empêcher les tentatives d'usurpation

# par des services non administrateurs.

# Ici, le port 969 par exemple :

Port 2222

# Sur un réseau maitrisé, sshd doit écouter uniquement sur une interface

# du réseau d'administration, distincte de l'opérationnelle

# Ici, le serveur écoute sur l'adresse 192.168.254.3 sur le port 22.

ListenAddress 192.168.254.3:22

# Active la séparation des privilèges en créant un fils non privilégié

# pour prendre en charge le trafic réseau entrant pour éviter une escalade de privilège.

# Par défaut à yes

UsePrivilegeSeparation sandbox

# On proscrit l'accès sans mot de passe

PermitEmptyPasswords no

MaxAuthTries 3 # doit être strictement supérieur à 1

# Interdire la connexion en temps que root

PermitRootLogin no

# Affiche les informations de la dernière connexion

PrintLastLog yes

# AllowUsers permet de spécifier la liste des utilisateurs autorisés

# Ici, l'acces à fanfanlatulipe est restreint aux adresses IPs du réseau 192.168.254.0/24

# et bobotlebrocolis à 192.168.1.0/24

AllowUsers fanfanlatulipe@192.168.254/24 bobotlebrocolis@192.168.1/24

# AllowGroups permet de spécifier la liste des groupes autorisés

AllowGroups wheel@192.168.254/24 flore

# Bloquer la modification des variables d'environnement;

# Les variables d'environnement peuvent modifier le fonctionnement attendu de programme.

# La directive AcceptEnv permet d'autoriser la modification d'une variable.

# !!! Je n'ai pas trouvé de documentation sur cette directive !!!

PermitUserEnvironment no

# Permet d'éxecuter une commande à la connexion.

# Cela remplace la connexion.

# ForceCommand <command>

# Par exemple, une connexion à l'utilisateur reboot relancera la machine :

Match User reboot

ForceCommand reboot

# Désactivation de la redirection de flux

AllowTcpForwarding no

X11Forwarding no

ForwardX11Trusted no

##### Commandes expliqués plus haut #####

StrictModes yes

Ciphers aes256-ctr,aes192-ctr,aes128-ctr

# OpenSSH > 6.3

MACs hmac-sha2-512-etm@openssh.com,hmac-sha2-256-etm@openssh.com

# Anciennes versions

MACs hmac-sha2-512,hmac-sha2-265,hmac-sha1

Utilisation des clés pour un host

Il est possible d'automatiser l'utilisation d'une clé ssh grâce à une fichier config situé dans "~/.ssh".

Pour faire cela utilisez les lignes de config suivantes:

Host [DOMAIN]

HostName [DOMAIN]

IdentityFile [PATH_TO_SSH_KEY]

L'exemple d'utilisation le plus fréquent est un serveur distant dont l'adresse ne change pas comme par exemple un répo Git.

P.S. : Afin d'utiliser une clé SSH à la place de la paire username/password pour les répo git un changement dans l'adresse de remote est nécessaire ("https://github.com/[repo]" à "git@github.com:[repo]")

Références

ANSSI :

IETF :

- RFC 4252 - Protocole d'authentification du client

- RFC 4253 - Protocole d'authentification sécurisé du serveur et établissement d'un canal de communication sécurisé

Divers :

Bastion d'administration

Définition

Un bastion d'administration ou plus simplement bastion est un équipement de rebond qui remplit plusieurs fonctions de sécurité (authentification, traçabilité, renouvellement des secrets). Cependant, le bastion constitue une ressource d'information critique car il contient des secrets d'authentification critique et les journaux liés aux actions d'administriation. Il est donc nécessaire qu'un bastion ne soit pas exposé sur un SI de faible niveau de confiance.

Enfin, un bastion ne doit être déployé que si la présence d'un équipement de rebond est jugé pertinente et si le niveau de confiance de l'équipement est satisfaisant.

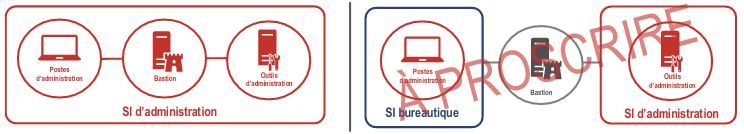

Comme mentionné dans les recommandations de l'ANSSI sur la protection des systèmes d'information essentiels et sur l'administration sécurisée des systèmes d'information:

La solution qui consiste à déployer un bastion comme moyen d’interconnexion depuis un poste d’un SI bureautique vers un SI d’administration est à proscrire. Elle procure un sentiment de sécurité injustifié puisqu’en réalité le bastion, porte d’entrée unique vers le SI d’administration, constitue une opportunité d’attaque importante, par exemple depuis un poste bureautique compromis depuis Internet.

Rupture protocolaire

Les actions d'administration necessitent des besoins forts en traçabilité et en confidentialité.

Il peut donc être souhaitable de mettre en place une rupture protocolaire pour assurer la traçabilité des connexions, un certain nombre de filtrage ou pour compenser la faiblesse de sécurité des protocoles d'administration.

Il est important de noter qu'avec une rupture protocolaire, la session sécurisée peut être rompu. C'est pour cela qu'il est préférable de renoncer à la rupture protocolaire pour des besoins de confidentialité.

Utilisation

Il existe deux implémentations du bastion ssh :

- ForwardAgent

- ProxyJump

Dû aux problèmes de sécurité qu'implique l'implémentation ForwardAgent, nous n'aborderons que ProxyJump dans ce guide.

La transmission de l’agent doit être activée avec prudence. Les utilisateurs ayant la possibilité de contourner les autorisations sur l’hôte distant (pour la chaussette UNIX de l’agent) peuvent accéder à l’agent local via la connexion transférée. Un attaquant ne peut pas obtenir de clé de l’agent, mais il peut effectuer des opérations sur les clés qui lui permettent de s’authentifier en utilisant les identités chargées dans l’agent. (source du manuel)

ProxyJump dynamique

Nous allons nous connecter à host2 en passant par host1, sans rupture protocolaire.

ssh -J host1 host2

Il est également possible de le faire avec des utilisateurs définis :

ssh -J user1@host1 user2@host2

ProxyJump statique

Il est possible de configurer dans .ssh/config :

# On renseigne le bastion

Host bastion

HostName host1

Host server

HostName host2

ProxyJump bastion

ssh server

Référenciels

ANSSI :

- Recommandations sur la portection des systèmes d'information essentiels

- Recommandations relatives à l'administration sécurisée des systèmes d'information

DNS

Par ce salop de FanfanlaTulipe

Un DNS (Domain Name System) est un système hiérarchique et décentralisé, utilisé pour identifier les différentes machines d'un réseau avec des noms, et non des adresses IP.

Plusieurs services de DNS existent :

- Bind9

- nsd

- Knot

- powerDNS

Les exemples suivants ont été fait avec un bind9.

Start Of Authority

salo.pe. IN SOA ns.salo.pe. root.salo.pe. (

25112101 ; serial

3600 ; refresh

900 ; retry

3600 ; expire

200 ; minimum

)

La SOA est l'information la plus importante d'un enregistrement DNS. Il va permettre de donner plusieurs informations aux autres DNS :

- Le nom de la zone (salo.pe)

- La classe de réseau (IN)

- Le type d'enregistrement (SOA)

- Le master name (ns.salo.pe)

- L'adresse mail du responsable (root.salo.pe)

- Le serial, il doit être incrémenté à chaque changement. Communément, il s'agit du jour, mois et année et une version (ddmmyyvv par exemple).

- Le refresh, définit le temps d'attente entre chaque demande du fichier pour les autres DNS.

- Le retry, définit le temps d'attente d'une nouvelle demande si le fichier n'est pas disponible.

- Le expire, définit combien de temps le fichier de zone est valide.

- Le minimum, définit le time to live dans le cache d'un client

Name Server

salo.pe IN NS ns.salo.pe

Le Name Server (NS) indique quel DNS fait autorité pour ce domaine.

A

salo.pe IN A <IPv4>

Les enregistrements de type A définissent les enregistrements pour les IPv4.

AAAA

salo.pe IN AAAA <IPv6>

Les enregistrements de type AAAA définissent les enregistrements pour les IPv6.

Text

acme IN TXT "Hello There"

Les enregistrements de type text (TXT) permettent d'entrer un texte pour un DNS. Ce type est utilisé par exemple par certbot et letsencrypt pour délivrer des certificats.

Mail eXchanger

salo.pe IN MX 1 mail.salo.pe

Les enregistrements MX permettent de spécifier un serveur de mail pour le domaine.

Canonical NAME

magnifique.salo.pe IN CNAME belle.salo.pe

Les enregistrements CNAME permettent de donner des alias à des noms de domaines.

$TTL

$TTL 5m

Le $TTL définit combien de temps les clients DNS garde en cache l'enregistrement.

Exemple

$TTL 5m

salo.pe. IN SOA ns.salo.pe. root.salo.pe. (

25112103

3600

900

3600

200

)

IN NS ns.salo.pe

IN A <IPv4>

ns IN A <IPv4>

mail IN A <IPv4>

belle IN A <IPv4>

belle IN AAAA <IPv6>

magnifique IN CNAME belle.salo.pe

acme IN TXT "Some text"

salo.pe IN MX mail.salo.pe

bind9

bind9 est un service linux offrant un serveur DNS.

Plusieurs fichiers sont intéressants concernant le service bind9 :

named.confet ses dérivés (named.conf.localetnamed.conf.options)- le fichier de zone, ici

salo.pe.zone

named

Dans /etc/bind/, on trouve named.conf et ses dérivés. named.conf ne nous intéressera pas ici, ce dernier inclut les autres fichiers (et on fait les choses proprement).

named.conf.local

Ce fichier va permettre à bind9 de trouver les fichiers de zone.

zone "salo.pe." {

type master;

file "/var/lib/bind/salo.pe.zone";

notify no;

};

type: défini le type de zone. Les types de zone disponibles sont les suivants :master: désigne le serveur faisant autorité pour cette zone.slave: désigne le serveur de noms comme serveur esclave de cette zone.forward: retransmet toutes les requêtes à propos de cette zone vers d'autres serveurs de noms.

file: le chemin du fichier de zonenotify: définit si les serveurs esclaves sont notifiés d'un changement de configuration.yesnoexplicit: notifie seulement les serveurs esclaves spécifiés dans une listealso-notify.

allow-transfer: spécifie les serveurs autorisés à recevoir un transfert de zone depuis ce serveur.also-notify: spécifie les serveurs à notifier lors d'un changement de configuration.

Il existe d'autres options, voir la référence ci-dessous.

Pour plus d'information sur la configuration de zone, voir ici.

Enfin, voir ici pour un exemple de la documentation.

named.conf.options

Ce fichier permet de spécifier des options à bind9.

options {

directory "/var/cache/bind";

allow-recusion { any; };

};

directory: défini le cache de bind9.allow-recursion: spécifie les serveurs autorisés à faire des requêtes récursives sur ce serveur.

Pour voir toutes les options disponibles, voir ici.

Fichier de zone

Le fichier de zone définit les enregistrements DNS, expliqués plus haut.

Commandes utiles

named-checkconf named.conf

named-checkzone <nom du domaine> <chemin du fichier de zone>

Références

ANSSI - Bonnes pratiques pour l'acquisition et l'exploitation de noms de domaine

DNSSEC

DNS Secuity Extensions (DNSSEC) est une spécification qui sert à garantir l'intégrité des données transmises par le DNS. DNSSEC va donc signer les enregistrements DNS d'une zone.

Tout d'abord, pour activer l'utilisation de DNSSEC dans notre bind9, il faut aller dans /etc/bind/named.conf.options et ajouter les lignes suivantes dans l'options { }:

dnssec-enable yes;

dnssec-validation yes;

dnssec-lookaside auto;

On va ensuite créer un biclé pour signer la zone (ZSK pour Zone Signing Key) :

dnssec-keygen -a ECDSAP256SHA256 -b 2048 -n ZONE salo.pe

La commande va créer un biclé :

Generating key pair.

Ksalo.pe.+001+01010

On va également créer un biclé pour signer notre clé précédente (KSK pour Key Signing Key) :

dnssec-keygen -f KSK -a ECDSAP256SHA256 -b 2048 -n ZONE salo.pe

Generating key pair.

Ksalo.pe.+002+02020

On va maintenant créer 4 clés publiques / privées. Il faut maintenant ajouter les clés publiques (qui contiennent des enregistrements DNSKEY) à notre fichier de zone :

for key in $(ls Ksalo.pe*.key); do

echo "\$INCLUDE $key" >> salo.pe.zone

done

Il faut maintenant signer le fichier de zone avec :

dnssec-signzone -3 $(head -c 1024 /dev/urandom | sha1sum | cut -b 1-16) -N INCREMENT -o salo.pe -t salo.pe.zone

Verifying the zone using the following algorithms:

- ECDSAP256SHA256

Zone fully signed:

Algorithm: ECDSAP256SHA256: KSKs: x active, x stand-by, x revoked

ZSKs: x active, x stand-by, x revoked

salo.pe.zone.signed

Signatures generated: xx

Signatures retained: x

Signatures dropped: x

Signatures successfully verified: x

Signatures unsuccessfully verified: x

Signing time in seconds: x.xxx

Signatures per second: xxx.xxx

Runtime in seconds: x.xxx

La commande a généré un fichier signé, nommé dans notre cas salo.pe.zone.signed. Ce dernier contient maintenant les enregistrements RRSIG. Il ne reste plus qu'à dire à bind9 que le fichier de zone a changé (dans /etc/bind/named.conf.local) :

zone "salo.pe." {

type master;

file "/var/lib/bind/salo.pe.zone.signed";

notify no;

};

On va recharger bind9 :

service bind9 reload

Et on va tester notre enregistrement DNSKEY :

dig DNSKEY salo.pe. @locahost

; <<>> DiG 9.16.23 <<>> DNSKEY salo.pe @pi

;; global options: +cmd

;; Got answer:

;; ->>HEADER<<- opcode: QUERY, status: NOERROR, id: 6915

;; flags: qr aa rd ra; QUERY: 1, ANSWER: 2, AUTHORITY: 0, ADDITIONAL: 1

;; OPT PSEUDOSECTION:

; EDNS: version: 0, flags:; udp: 1232

; COOKIE: xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx (good)

;; QUESTION SECTION:

;salo.pe. IN DNSKEY

;; ANSWER SECTION:

salo.pe. 300 IN DNSKEY 257 3 14 N2IdneSgXq9qtbI7tkbdJn1eNpMrCp1ahWQkXllcshQMoR5n38bdVigy BIpkQE2urSvAsh3sDLziREvlbVbTD+tjqadvIzjAFJd+/R4xd7EqPNiK XMONjcjsf5Eld5S8

salo.pe. 300 IN DNSKEY 256 3 14 WEW+NXfKvEoYHknb3AV5FitgFUzhaf6ztPIMCyvFhhrjkrwANfFIThcw 8LXbLqghVkhJhoTdp7cMHbn2VoIbcoo2nypNH2xIYojlpcG8IDR4+FfL 912Qpemm5hhYqid1

;; Query time: xx msec

;; SERVER: xxx.xxx.xxx.xxx#xxx(xxx.xxx.xxx.xxx)

;; WHEN: Sat Nov 27 08:04:06 CET 2021

;; MSG SIZE rcvd: xxx

On va également tester la présence de l'enregistrement RRSIG :

dig A wiki.salo.pe @localhost +dnssec

; <<>> DiG 9.16.23 <<>> A wiki.salo.pe @pi +dnssec

;; global options: +cmd

;; Got answer:

;; ->>HEADER<<- opcode: QUERY, status: NOERROR, id: 24670

;; flags: qr aa rd ra; QUERY: 1, ANSWER: 2, AUTHORITY: 0, ADDITIONAL: 1

;; OPT PSEUDOSECTION:

; EDNS: version: 0, flags: do; udp: 1232

; COOKIE: xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx (good)

;; QUESTION SECTION:

;wiki.salo.pe. IN A

;; ANSWER SECTION:

wiki.salo.pe. 300 IN A xxx.xxx.xxx.xxx

wiki.salo.pe. 300 IN RRSIG A 14 3 300 20211227055627 20211127055627 64607 salo.pe. q3oc64GzeiDmN1qIoRSa64fb/UxGdDAO7gYIP34JUEfluchSYcU3yml1 W2aHznpkQRggy2es/whFljsOq84Q2p60KmO6tmbPBB/ptSpEN0jnlSTt FTxsJWD5Bdkcf9Lo

;; Query time: xx msec

;; SERVER: xxx.xxx.xxx.xxx#xxx(xxx.xxx.xxx.xxx)

;; WHEN: Sat Nov 27 08:04:47 CET 2021

;; MSG SIZE rcvd: xxx

Voici un script pour générer le fichier de zone signé (ici dans Ansible) :

#!/bin/sh

DIR="<chemin vers un dossier>"

REGEX_ALL_KEYS="<regex pour les clés>" # avec l'exemple, Ksalo.pe*

REGEX_PUBLIC_KEYS="<regex pour les clés publiques>" # Ksalo.pe.*.key

ZONE_FILE="<fichier de zone>" # salo.pe.zone

SIGNED_ZONE_FILE="<fichier de zone signé>" # salo.pe.zone.signed

DOMAIN="<domaine>" # salo.pe

# On va utiliser notre fichier de zone (salo.pe.zone) et en faire un

# fichier de base, qui sera copié à chaque execution.

# cp salo.pe.zone salo.pe.zone.base

BASE_ZONE_FILE="<fichier de zone d'origine>"

rm $DIR/$REGEX_ALL_KEYS $DIR/$ZONE_FILE $DIR/$SIGNED_ZONE_FILE

set -e

dnssec-keygen -K $DIR -a ECDSAP256SHA256 -b 2048 -n ZONE $DOMAIN

dnssec-keygen -K $DIR -f KSK -a ECDSAP256SHA256 -b 2048 -n ZONE $DOMAIN

cp "$DIR/$BASE_ZONE_FILE" "$DIR/$ZONE_FILE"

for key in $(ls $DIR/$REGEX_PUBLIC_KEYS); do

echo "\$INCLUDE $key" >> "$DIR/$ZONE_FILE"

done

dnssec-signzone -A -3 $(head -c 2048 /dev/urandom | sha1sum | cut -b 1-16) -K $DIR -N INCREMENT -o $DOMAIN -t $DIR/$ZONE_FILE

Sommaire

Par ces salops de Kuro et FanfanlaTulipe

Bienvenue sur ce guide abordant plusieurs sujets concernant la meilleure distribution Linux de cette planête, Arch Linux.

Vous trouverez ci-dessous tous les sujets abordés dans ces guides. Ils peuvent concernés des thèmes spécifiques à Arch Linux ou bien des thèmes plus généraux, applicable à Linux.

- Installation d'un Dualboot Windows 10 / Arch Linux chiffré

- Network Manager, outil de gestion des réseaux

- Yet Another Yogurt, excellent gestionnaire de paquet

- Zsh, meilleur shell

- i3, best window manager ever

- Multi-écran

- Système de notification

- Systemd

- Optimisation de la durée de vie de la batterie

- Luminosité de l'écran

Sommaire

Par ces salops de Kuro et FanfanlaTulipe

Bienvenue sur ce guide abordant plusieurs sujets concernant la meilleure distribution Linux de cette planête, Arch Linux.

Vous trouverez ci-dessous tous les sujets abordés dans ces guides. Ils peuvent concernés des thèmes spécifiques à Arch Linux ou bien des thèmes plus généraux, applicable à Linux.

- Installation d'un Dualboot Windows 10 / Arch Linux chiffré

- Network Manager, outil de gestion des réseaux

- Yet Another Yogurt, excellent gestionnaire de paquet

- Zsh, meilleur shell

- i3, best window manager ever

- Multi-écran

- Système de notification

- Systemd

- Optimisation de la durée de vie de la batterie

- Luminosité de l'écran

Prérequis

Par ces salops de Kuro et FanfanlaTulipe

Ce wiki se base sur les tutoriels suivants :

Il est préférable d'avoir installer Windows 10 (où l'installer) et de sauvergarder toutes les données importantes présents sur l'ordinateur en cas d'échec.

Ce guide ne sera pas responsable de quelconques saloperies que vous pourriez faire !

Télécharger l'ISO d'Arch Linux et créer une clé d'installation avec Rufus par exemple.

Vérifier que le SecureBoot est désactivé dans le BIOS.

Désactiver le démarrage rapide dans les paramètres Windows.

Windows

Général

Assurez-vous d'avoir de la place sur votre disque pour l'installation d'Arch Linux avec l'utilitaire de partition Windows. Il est conseillé de laisser au moins 50Go à Windows pour qu'il fonctionne correctement, mais laissez-en plus si vous comptez l'utiliser dans de bonnes conditions.

Avec la commande regedit, ajouter au registre une valeur DWORD dans le registre HKEY_LOCAL_MACHINE\SYSTEM\CurrentControlSet\Control\TimeZoneInformation\RealTimeIsUniversal :

- nouvelle valeur DWORD

- affecter la valeur 1

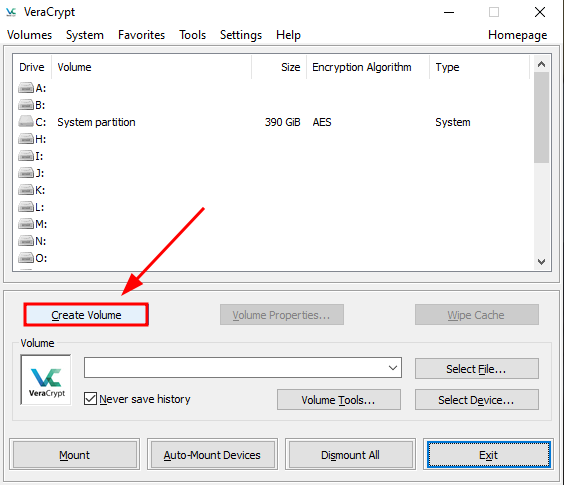

Enfin, télécharger et installer VeraCrypt.

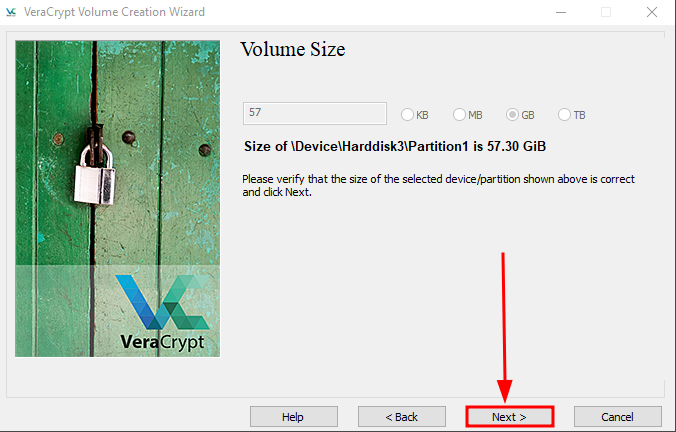

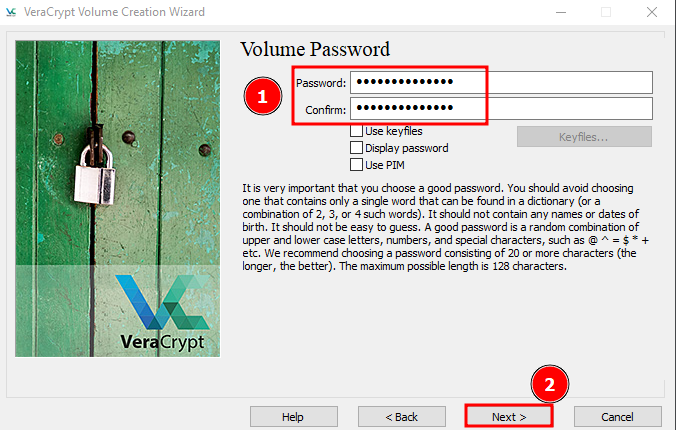

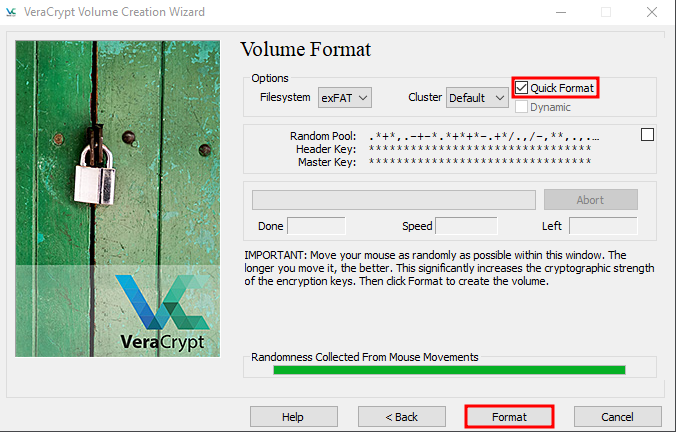

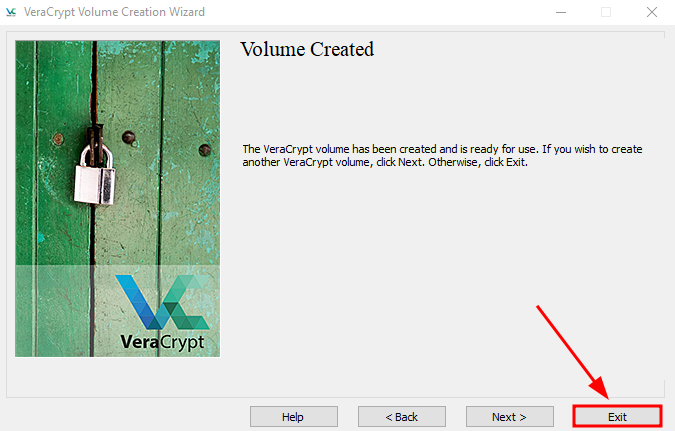

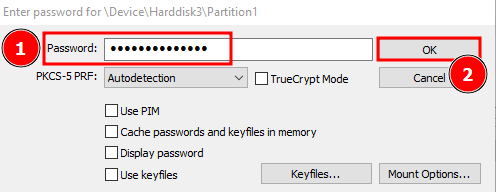

Veracrypt

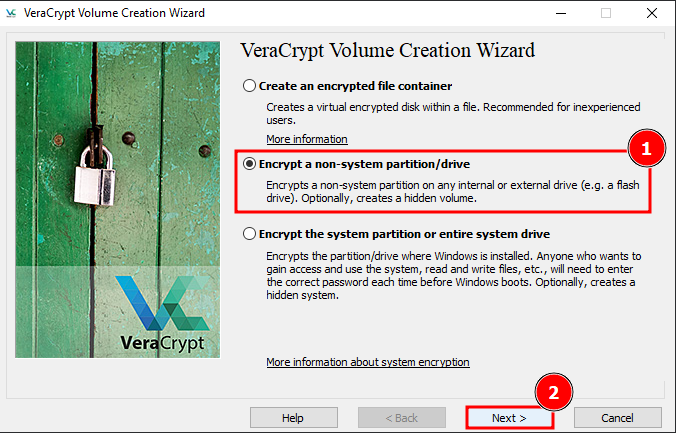

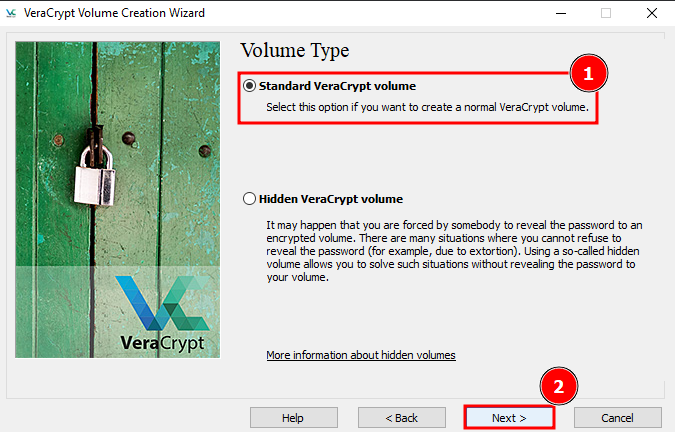

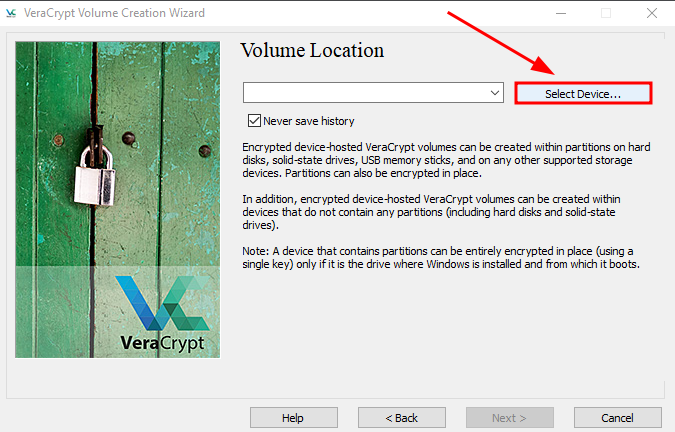

Système > Chiffrer le disque/les partitions systemes- Sélectionner

Normal. - Sélectionner

Chiffrer les partitions système Windows. - Sélectionner

Single boot. - Sélectionner l'algorithme de chiffrement que vous souhaitez.

- Choisir un mot de passe robuste.

- Retenir le mot de passe robuste.

- Bouger la souris ou taper au clavier pendant la génération des clés de chiffrement.

- Lancer le test de chiffrement.

- Une fois le système redémarré, valider le chiffrement total du système.

Arch Linux

Brancher la clé d'installation créée plus haut et démarrer l'ordi sur cette clé. Quand Arch Linux a démarré, choisir Boot Arch Linux.

Pour mettre le clavier en AZERTY :

loadkeys fr-latin1

Se connecter à Internet si ce n'est pas le cas :

iwctl

station <wlan device name> connect <wifi-station-name>

Pour vérifier que l'ordinateur soit bien connecté à Internet : ping google.com.

On va également ajouter dm_crypt dans les modules kernel explicitement :

modprobe dm_crypt

On va mettre l'ordinateur à l'heure :

timedatectl set-ntp true

Si vous souhaitez procéder à l'installation depuis une autre machine :

- Sur la machine cible :

passwd

systemctl start sshd # n'est pas forcément nécessaire

ip a # Pour voir l'IP

- Sur votre machine :

ssh root@<IP>

Prérequis

Par ces salops de Kuro et FanfanlaTulipe

Ce wiki se base sur les tutoriels suivants :

Il est préférable d'avoir installer Windows 10 (où l'installer) et de sauvergarder toutes les données importantes présents sur l'ordinateur en cas d'échec.

Ce guide ne sera pas responsable de quelconques saloperies que vous pourriez faire !

Télécharger l'ISO d'Arch Linux et créer une clé d'installation avec Rufus par exemple.

Vérifier que le SecureBoot est désactivé dans le BIOS.

Désactiver le démarrage rapide dans les paramètres Windows.

Windows

Général

Assurez-vous d'avoir de la place sur votre disque pour l'installation d'Arch Linux avec l'utilitaire de partition Windows. Il est conseillé de laisser au moins 50Go à Windows pour qu'il fonctionne correctement, mais laissez-en plus si vous comptez l'utiliser dans de bonnes conditions.

Avec la commande regedit, ajouter au registre une valeur DWORD dans le registre HKEY_LOCAL_MACHINE\SYSTEM\CurrentControlSet\Control\TimeZoneInformation\RealTimeIsUniversal :

- nouvelle valeur DWORD

- affecter la valeur 1

Enfin, télécharger et installer VeraCrypt.

Veracrypt

Système > Chiffrer le disque/les partitions systemes- Sélectionner

Normal. - Sélectionner

Chiffrer les partitions système Windows. - Sélectionner

Single boot. - Sélectionner l'algorithme de chiffrement que vous souhaitez.

- Choisir un mot de passe robuste.

- Retenir le mot de passe robuste.

- Bouger la souris ou taper au clavier pendant la génération des clés de chiffrement.

- Lancer le test de chiffrement.

- Une fois le système redémarré, valider le chiffrement total du système.

Arch Linux

Brancher la clé d'installation créée plus haut et démarrer l'ordi sur cette clé. Quand Arch Linux a démarré, choisir Boot Arch Linux.

Pour mettre le clavier en AZERTY :

loadkeys fr-latin1

Se connecter à Internet si ce n'est pas le cas :

iwctl

station <wlan device name> connect <wifi-station-name>

Pour vérifier que l'ordinateur soit bien connecté à Internet : ping google.com.

On va également ajouter dm_crypt dans les modules kernel explicitement :

modprobe dm_crypt

On va mettre l'ordinateur à l'heure :

timedatectl set-ntp true

Si vous souhaitez procéder à l'installation depuis une autre machine :

- Sur la machine cible :

passwd

systemctl start sshd # n'est pas forcément nécessaire

ip a # Pour voir l'IP

- Sur votre machine :

ssh root@<IP>

Partitions des disques

Nous utiliserons cfdisk pour gérer les partitions des disques. Nous partitionnerons un ssd classique, /dev/nvme0n1.

fdisk -l # Pour voir la liste des partitions disponibles

cfdisk /dev/nvme0n1

Nous allons donc créer 3 partitions :

| Nom de la partition | Point de montage | Partition | Taille suggérée |

|---|---|---|---|

| boot | /boot | /dev/nvme0n1p5 | 512 Mo |

| root | / | /dev/nvme0n1p6 | >= 50 Go |

| home | /home | /dev/nvme0n1p7 | Le reste |

La partition de swap sera virtuel.

Nous utiliserons la partition EFI de Windows. Vous pouvez la localiser avec un fdisk -l.

Dans le cas d'une disposition BIOS ou MBR :

Nom de la partition Point de montage Taille suggérée [SWAP] - Au moins la taille de votre RAM root /Le reste

Création des partitions

Avant tout, nous allons executer fdisk -l pour connaitre le nombre de partition déjà présente sur le disque. Dans notre exemple, la commande sort :

Disk /dev/nvme0n1: 476.94 GiB, 512110190592 bytes, 1000215216 sectors

Disk model: **************************

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disklabel type: gpt

Disk identifier: ********-****-****-****-************

Device Start End Sectors Size Type

/dev/nvme0n1p1 2048 206847 204800 100M EFI System

/dev/nvme0n1p2 206848 239615 32768 16M Microsoft reserved

/dev/nvme0n1p3 239616 101374679 101135064 48.2G Microsoft basic data

/dev/nvme0n1p4 101376000 102397951 1021952 499M Windows recovery environment

On a donc 4 partitions déjà présentes. Nous allons donc créer les partitions 5, 6 et 7.

Boot

- Aller sur

Free space. - Entrer dans

[ New ]. - Entrer la taille souhaitée, ici

512M.

Notre partition /dev/nvme0n1p5 est créée, de type Linux filesystem.

Root

Il est recommandé de laisser 50Go à cette partition.

- Aller sur

Free space. - Entrer dans

[ New ]. - Entrer la taille souhaitée, ici

50G.

Notre partition /dev/nvme0n1p6 est créée, de type Linux filesystem.

Home

- Aller sur

Free space. - Entrer dans

[ New ]. - Entrer la taille souhaitée, ici la taille restant du disque.

Notre partition /dev/nvme0n1p7 est créée, de type Linux filesystem.

Application des changements

Entrer [ Write ] pour écrire les changements puis [ Quit ].

Félicitations, vous avez partitionné votre disque. Il va maintenant falloir formater correctement les partitions.

Dans notre exemple, nous utilisons toujours /dev/nvme0n1 comme disque, nous avons en conséquence :

- /dev/nvme0n1p5 pour la partition boot.

- /dev/nvme0n1p6 pour la partition root.

- /dev/nvme0n1p7 pour les données utilisateurs.

Afin de faciliter la suite de l'installation, nous définirons des variables :

export efi=/dev/nvme0n1p1

export boot=/dev/nvme0n1p5

export root=/dev/nvme0n1p6

export home=/dev/nvme0n1p7

Chiffrer les partitions

Dans le bonne pratique d'installation, il est recommandé de chiffrer ses partitions afin d'empêcher une personne de monter vos disques et de récupérer vos données.

Les commandes suivantes servent à écraser les données déjà existantes sur les partitions. Ces commandes sont donc optionnelles.

cryptsetup open --type plain -d /dev/urandom $root to_be_wiped # Ecraser la partition root

dd if=/dev/zero of=/dev/mapper/to_be_wiped status=progress

cryptsetup close to_be_wiped

cryptsetup open --type plain -d /dev/urandom $home to_be_wiped # Override home partition

dd if=/dev/zero of=/dev/mapper/to_be_wiped status=progress

cryptsetup close to_be_wiped

On va maintenant chiffrer la partition root avec un mot de passe et la partition home avec un fichier, ici 20ko de données aléatoire. On va également créer un volume swap de 24Go, ce n'est pas obligatoire.

cryptsetup -y luksFormat $root # chiffre root avec un mot de passe

dd if=/dev/urandom of=keyfile bs=1024 count=20 # génére un fichier de 20ko aleatoire

cryptsetup --key-file keyfile luksFormat $home # chiffre home avec le fichier aleatoire

cryptsetup luksOpen $root crypt_root

cryptsetup --key-file keyfile luksOpen $home crypt_pool

lvm pvcreate /dev/mapper/crypt_pool

lvm vgcreate lvmpool /dev/mapper/crypt_pool

lvm lvcreate -L 24GB -n swap lvmpool # la taille de la partition SWAP doit être supérieur ou égale à la taille de votre RAM pour pouvoir hiberner

lvm lvcreate -l 100%FREE -n home lvmpool

Formattage des partitions

Nous allons commencer par formatter les partitions.

Si vous avez du swap :

mkswap /dev/mapper/lvmpool-swap

swapon /dev/mapper/lvmpool-swap

Pour le boot et le filesystem :

mkfs.ext4 $boot

mkfs.ext4 /dev/mapper/crypt_root

mkfs.ext4 /dev/mapper/lvmpool-home

Bien joué, c'est formatté !

Monter les partitions filesystem

Une fois nos partitions créées et formattées, il faut monter les partitions filesystem pour travailler dedans.

mount /dev/mapper/crypt_root /mnt

mkdir /mnt/boot

mkdir /mnt/home

mount $boot /mnt/boot

mount /dev/mapper/lvmpool-home /mnt/home

mkdir /mnt/boot/efi

mount $efi /mnt/boot/efi

Les partitions sont maintenant montées et prêtes à l'emploi.

La base et le chroot

pacstrap

Pacstrap sert à installer les systemes nécessaires à la survie de cette magnifique distribution qu'est Arch Linux. La première commande ci-dessous est la commande avec les paquets minimums, vous pouvez cependant télécharger les paquets que vous souhaitez. Il est conseillé d'installer les paquets suivants :

baselinuxou un autre paquet noyaulinux-firmwareou un autre micrologiciel- un gestionnaire de réseau, ici

networkmanager - un éditeur de texte, ici

vim

# Nous aurons ici besoin des paquets suivants

pacstrap /mnt gimp base linux linux-firmware \ # Paquets nécessaires à arch linux

grub \ # Nous reviendrons dessus plus tard

efibootmgr \ # utile pour GRUB

vim \

sudo \ # Nous reviendrons dessus plus tard

networkmanager \

lvm2

Cela va installer tous les paquets de base (ça peut prendre quelques minutes).

Si

pacstrapsort une erreur du type :error: pam: signature from "John Doe <john@doe.com>" is unknown trust :: File /mnt/var/cache/pacman/pkg/pam-1.5.2-1-x86_64.pkg.tar.zst is corrupted (invalid or corrupted package (PGP signature)). Do you want to delete it? [Y/n]Lancer la commande suivante puis relancer la commande

pacstrap:pacman -Sy archlinux-keyring

Déchiffrement automatique

Copier le fichier de clé dans /mnt/root.

cp keyfile /mnt/root

Trouver la valeur de la partition home dans ls -l /dev/disk/by-uuid. Ici 4517ff0f-deab-4564-90ca-e4f4947b8ca3 :

total 0

lrwxrwxrwx 1 root root 10 Dec 4 10:37 3c07c1fb-8c95-4b86-b133-be0dbcf94e44 -> ../../dm-0

lrwxrwxrwx 1 root root 10 Dec 4 09:57 4A6B-045F -> ../../sda1

lrwxrwxrwx 1 root root 10 Dec 4 10:37 8f885dc4-2292-48a0-a319-b9045a300d93 -> ../../dm-3

lrwxrwxrwx 1 root root 15 Dec 4 10:32 4517ff0f-deab-4564-90ca-e4f4947b8ca3 -> ../../nvme0n1p7

lrwxrwxrwx 1 root root 15 Dec 4 10:37 51565f90-9666-47fc-ba13-85c1bdb016eb -> ../../nvme0n1p5

lrwxrwxrwx 1 root root 15 Dec 4 09:57 C6B27122B27117DF -> ../../nvme0n1p4

lrwxrwxrwx 1 root root 15 Dec 4 09:57 D2A6-C16F -> ../../nvme0n1p1

lrwxrwxrwx 1 root root 15 Dec 4 09:57 FC5AA8015AA7B734 -> ../../nvme0n1p3

lrwxrwxrwx 1 root root 15 Dec 4 10:31 ad022385-b683-4e48-8e66-3cb027b67a9a -> ../../nvme0n1p6

lrwxrwxrwx 1 root root 10 Dec 4 10:35 bc05acd8-90a2-43e8-922a-df890c3a11ad -> ../../dm-2

Ajouter crypt_hdd UUID=xyz /root/keyfile luks dans /mnt/etc/crypttab avec xyz étant la valeur trouvée précédement :

crypt_hdd UUID=4517ff0f-deab-4564-90ca-e4f4947b8ca3 /root/keyfile luks

TRIM

TRIM va permettre d'augmenter la durée de vie d'un SSD si ce dernier est chiffré.

Si l'on se trouve sous ssd (ce qui est notre cas) :

- on vérifie que notre SSD supporte l'usage de TRIM. Une valeur différente de zéro indique le support de TRIM :

lsblk --discard

- dans

/mnt/etc/crypttab, ajouterdiscardaprèsluks:

crypt_hdd UUID=4517ff0f-deab-4564-90ca-e4f4947b8ca3 /root/keyfile luks discards

- dans

/mnt/etc/lvm/lvm.conf, activerissue_discards. (S'il n'existe pas, copier/etc/lvm/lvm.confd'abord) systemctl enable fstrim.serviceetsystemctl enable fstrim.timer.

Référence sur TRIM :

arch-chroot

On va ensuite générer notre table de fichiers (fstab) et lancer le système.

genfstab -U /mnt >> /mnt/etc/fstab

arch-chroot /mnt

Nous sommes maintenant dans notre systeme de fichier, en tant que root.

Time

ln -sf /usr/share/zoneinfo/Europe/Paris /etc/localtime

hwclock --systohc

Langue

On va maintenant définir le locale, soit la langue de l'ordinateur.

vim /etc/locale.gen

Vous arrivez dans un gros fichier où toutes les lignes sont commentées. Trouvez la langue souhaitée et décommentez là.

en_US.UTF-8 UTF-8 # Pour l'anglais

fr_FR.UTF-8 UTF-8 # Pour le français

locale-gen

On peut également changer le keymap, c'est à dire la disposition du clavier au niveau du système. Ouvrir /etc/vconsole.conf :

# us par défaut

KEYMAP=fr # pour mettre en français

Hostname & hostfile

echo "<hostname>" > /etc/hostname

vim /etc/hosts

Entrer la configuration suivante, remplacer

127.0.0.1 localhost

::1 localhost

127.0.1.1 <hostname>.localdomain <hostname>

Initramfs et GRUB

Initramfs

initramfs est un schéma pour charger une image temporaire de systèmes de fichiers permettant le démarrage du noyau Linux.

Il faut mettre keyboard avant modconf et ajouter keymap encrypt lvm2 après block pour initramfs.

vim /etc/mkinitcpio.conf

HOOKS=(base udev autodetect keyboard modconf block keymap encrypt lvm2 filessytems fsck)

mkinitcpio -p linux

Référence : Wiki Arch Linux sur mkinitcpio

GRUB

GRUB est un boot loader qui vous nous permettre de choisir sur quel systeme on souhaite démarrer une machine. Nous l'avons téléchargé précédement.

Partition chiffrée

Nous allons commencer par trouver les UUID de la partition root et efi :

blkid

/dev/nvme0n1p1: UUID="C423-D675" BLOCK_SIZE="512" TYPE="vfat" PARTLABEL="EFI system partition" PARTUUID="b1070c21-2d6f-434f-80c3-37cdd3e5899b"

/dev/nvme0n1p4: BLOCK_SIZE="512" UUID="7C66315266310E80" TYPE="ntfs" PARTUUID="9ae311e5-026b-418b-be9b-4bfbabcf914d"

/dev/nvme0n1p5: UUID="546c759f-924d-4811-b853-84c328ca55f2" BLOCK_SIZE="4096" TYPE="ext4" PARTUUID="618fc4b6-6cf9-834d-82b0-978c6d4c6a8d"

/dev/nvme0n1p6: UUID="ad022385-b683-4e48-8e66-3cb027b67a9a" TYPE="crypto_LUKS" PARTUUID="af351b03-8486-e648-8358-8008f9b0b747"

/dev/nvme0n1p7: UUID="e473a1cb-95f7-4cfd-8770-9fcc07f0a52b" TYPE="crypto_LUKS" PARTUUID="3eaa5115-7707-d349-ab7b-c887854f8872"

/dev/sr0: UUID="731ac0004d532055" LABEL="CCCOMA_X64FRE_EN-US_DV9" BLOCK_SIZE="2048" TYPE="udf"

/dev/sda1: LABEL="ARCH_202104" UUID="4A6B-045F" BLOCK_SIZE="512" TYPE="vfat" PARTUUID="001304a7-01"

/dev/loop0: TYPE="squashfs"

/dev/mapper/crypt_pool: UUID="B4xto1-7Fwb-layI-wWdY-yoxu-68CF-7WZYUt" TYPE="LVM2_member"

/dev/nvme0n1p3: PARTLABEL="Basic data partition" PARTUUID="2079ff68-8dc3-46f5-a18a-80077802e160"

/dev/nvme0n1p2: PARTLABEL="Microsoft reserved partition" PARTUUID="38cadc6a-a4d2-4b59-98ac-76fa03d0f95a"

/dev/mapper/lvmpool-home: UUID="50ec36ca-ab6a-42f9-aa33-6e17f181a8c9" BLOCK_SIZE="4096" TYPE="ext4"

/dev/mapper/crypt_root: UUID="85dfd718-6b00-4dd8-bd69-cf0ad366f28f" BLOCK_SIZE="4096" TYPE="ext4"

Ici, l'UUID de root est ad022385-b683-4e48-8e66-3cb027b67a9a et celui de efi est C423-D675.

Dans la configuration de grub (/etc/default/grub), nous allons modifier GRUB_CMDLINE_LINUX pour qu'il ait le format suivant :

GRUB_ONLINE_LINUX="cryptdevice=UUID=${ROOT_UUID}:crypt_root root=/dev/mapper/crypt_root"

Dans le cas où le SSD supporte TRIM (référence), mettre :

GRUB_ONLINE_LINUX="cryptdevice=UUID=${ROOT_UUID}:crypt_root:allow-discards root=/dev/mapper/crypt_root"

Windows 10

Dans /etc/grub.d/40_custom, Nous allons ajouter Windows 10 à GRUB. $FS_UUID est l'uuid de la partition efi :

#!/bin/sh

set -e

tail -n +3 $0

if [ "${grub_platform}" == "efi" ]; then

menuentry "Windows 10" {

insmod part_gpt

insmod fat

insmod search_fs_uuid

search --fs-uuid --set=root $FS_UUID

chainloader /EFI/VeraCrypt/DcsBoot.efi

}

fi

On va maintenant générer GRUB :

grub-install --target=x86_64-efi --recheck

grub-mkconfig -o /boot/grub/grub.cfg

Secure Boot

Il est possible de changer les commandes executés par GRUB au démarrage d'une machine et ainsi boot avec root sans mot de passe (Référence).

Nous ne verrons ici que la sécurisation de la version 2 de GRUB, la version 1 étant relativement peu utilisée.

Nous allons voir comment protéger la modification des commandes GRUB, afin de protéger notre machine au démarrage mais de ne pas avoir à entrer un mot de passe tout le temps. Notre machine est déjà chiffrée, ça suffit.

N'utilisez pas l'instruction password, elle requiert un mot de passe en clair. Nous utiliserons plutot grub-mkpasswd-pbkdf2 pour le hasher.

grub-mkpasswd-pbkdf2

Dans /etc/grub.c/40_custom, ajouter à la fin :

# Password

set superusers="<nom de l'utilisateur>"

password_pbkdf2 <nom de l'utilisateur> <le hash généré par grub-mkpasswd-pbkdf2>

Cela donne par exemple :

# Password

set superusers="supersaloperie"

password_pbkdf2 supersaloperie grub.pbkdf2.sha512.10000.3527FF766CC755FA99FD7BD74F30A5DF3E4C6DE0F2C48C9F573C53DA75D03FAC09B7A82FDA0276802393BEDB0BAE8C3AC4F882D3E87BAAC6E82F9EB5C959D4B4.FAE05D6223B15D24FFED8AD0489C421271B119D7C4F6921DF8A429E0EFD312EF279E3A720453C8066D39183B70016702AFE9C23A37B6AB877D5CB3328084798E

superusers acceuille une liste d'utilisateurs, séparés par des espace, virgules, point-virgules ou pipes (|). Si la liste est vide, cela désactive l'accès à la CLI et à la modification des commandes.

Afin que des entrées puissent être utilisées sans mot de passe, il est possible de rajouter --unrestricted après un menuentry. De la même manière, on peut restreindre l'accès à une entrée à un utilisateur en particulier avec --users "<les utilisateurs>" :

set superusers="supersaloperie"

password_pbkdf2 supersaloperie grub.pbkdf2.sha512.10000.[...]

password saloperie insecure

menuentry "Runnable by anyone" --unrestricted {

echo "Saloperie de Wiki"

halt

}

menuentry "Only supersaloperie" --users "" {

echo "Super Saloperie"

halt

}

menuentry "supersaloperie et saloperie" --users saloperie {

echo "Que les saloperies"

reboot

}

Pensez donc à passer dans tous vos fichiers de configuration (/etc/grub.d/) et ajouter --unrestricted ou --users <users> si vous le souhaitez. Quand cela est fait, recréer le fichier de configuration de grub :

grub-mkconfig -o /boot/grub/grub.cfg

Redemarrage sur l'OS precedement demarre

Dans certains cas il peut être intéressant de pouvoir enregistrer le dernier OS lancé afin de le lancer à nouveau au prochain redémarrage (AKA les MAJ Windows, si vous êtes en dual boot notamment). Pour arriver à ce résultat trois choix s'offrent à vous :

- lancer la commande de génération de grub citée plus haut :

grub-mkconfig -o /boot/grub/grub.cfgen précisantGRUB_DEFAULT=saveddevant - modifier le fichier /etc/default/grub pour y ajouter cette même variable :

GRUB_DEFAULT=savedet générer le fichier de config - deprecié ou modifier le fichier /boot/grub/grub.cfg, qui est généré par la commande juste au dessus

Dans le dernier cas voici les étapes pour parvenir à vos fins :

- au début du fichier vous devriez retrouvez ce bout de code, dans lequel

defaultdoit être égal à${saved_entry}dans le else

### BEGIN /etc/grub.d/00_header ###

insmod part_gpt

insmod part_msdos

if [ -s $prefix/grubenv ]; then

load_env

fi

if [ "${next_entry}" ] ; then

set default="${next_entry}"

set next_entry=

save_env next_entry

set boot_once=true

else

set default="${saved_entry}" <---- verifiez bien cette ligne

fi

- à chaque option du menu de grub un peu plus bas, dans les sections

### BEGIN /etc/grub.d/10_linux ###et/ou### BEGIN /etc/grub.d/30_os-prober ###, etc ... la lignesavedefaultdoit être la première ligne, voici un exemple avec Windows :

menuentry 'Windows 10 (sur /dev/sdax)' --class windows --class os $menuentry_id_option 'osprober-chain-UUID' {

savedefault <-------------- cette ligne la

insmod part_msdos

insmod ntfs

set root='hd1,msdos4'

if [ x$feature_platform_search_hint = xy ]; then

search --no-floppy --fs-uuid --set=root --hint-ieee1275='ieee1275//disk@0,msdos4' --hint-bios=hd1,msdos4 --hint-efi=hd1,msdos4 --hint-baremetal=ahci1,msdos4 UUID

else

search --no-floppy --fs-uuid --set=root UUID

fi

parttool ${root} hidden-

drivemap -s (hd0) ${root}

chainloader +1

}

Pensez à bien vérifier que la fonction savedefault est bien présente dans votre fichier.

Références :

Utilisateurs et mots de passe

Pour le moment, on ne connait pas le mot de passe du compte root. On va donc le changer :

passwd

Entrez votre mot de passe. Retenez le bien, il s'agit du mot de passe à ne pas oublier !

Il est ensuite recommandé d'ajouter un utilisateur "classique" et de l'utiliser. Le compte root ne doit être utilisé que lorsque c'est nécessaire !

J'appellerai mon utilisateur saloperie.

useradd -m saloperie

passwd saloperie

On va enfin ajouter notre nouvel utilisateur à certains groupes, comme le groupe wheel pour pouvoir utiliser sudo afin de ne pas se reconnecter en temps que root :

usermod -aG wheel,audio,video,optical,storage saloperie

sudo

On va ajouter les droits sudo à notre utilisateur mais sudo n'est pas intallé.

pacman -S sudo

On va ensuite éditer le fichier sudo :

EDITOR=vim

visudo

Dans le fichier, décommentez la ligne # %wheel ALL=(ALL) ALL et ajoutez la ligne Defaults insults après la liste de defaults.

Reboot et Vérification

On va redémarrer la machine.

exit # quitte arch-chroot

umount -R /mnt # démonte des partitions

reboot

Vérifiez maintenant que Windows et Arch Linux se lancent bien et fonctionnent correctement.

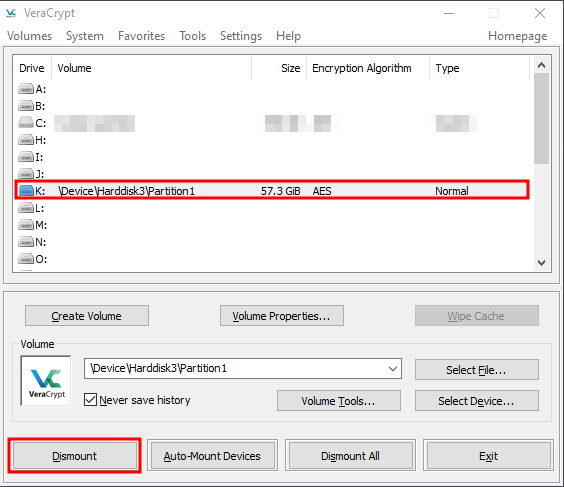

ATTENTION : un problème graphique existe concernant VeraCrypt. Si vous bootez sous Windows, il est possible que vous tombiez sur un écran noir. Entrez votre mot de passe puis votre code PIM (Taper ENTRER si vous n'en avez pas mis).

Pour rappel, le clavier est en mapping US pour le mot de passe VeraCrypt.

Internet

Corrigé par ce salop de F

Jusqu'à maintenant, nous avons utilisé iwctl pour gérer le wifi (si vous avez fait l'installation avec le wifi).

Nous allons passer une gestionnaire de réseau plus poussé et plus simple d'utilisation, Network Manager.

Network Manager

Network Manager est un programme qui va permettre la détection et la configuration des réseaux.

Installation

sudo pacman -S networkmanager

Ce paquet contient le démon Network Manager, nmcli et nmtui.

Pour vérifier que le démon tourne correctement, taper la commande suivante :

sudo systemctl status NetworkManager.service

Utilisation

nmcli

Nous n'aborderons ici que les connexions aux réseaux sans fil.

Il est possible d'utiliser networkmanager uniquement en ligne de commande mais son utilisation est vite fastidieuse quand il s'agit d'utiliser des réseaux aux connexions complexes.

Tout d'abord, faites la liste des réseaux disponibles avec :

nmcli device wifi list

IN-USE BSSID SSID MODE CHAN RATE SIGNAL BARS SECURITY

xx:xx:xx:xx:xx:xx FreeWifi_secure Infra xx xxx Mbit/s 74 ▂▄▆_ WPA2 802.1X

xx:xx:xx:xx:xx:xx Freebox-xxxxxx Infra xx xxx Mbit/s 70 ▂▄▆_ WPA2

xx:xx:xx:xx:xx:xx Livebox-xxxx Infra xx xxx Mbit/s 52 ▂▄__ WPA1 WPA2

xx:xx:xx:xx:xx:xx Freebox-xxxxxx Infra xx xxx Mbit/s 50 ▂▄__ WPA2

xx:xx:xx:xx:xx:xx FreeWifi_secure Infra xx xxx Mbit/s 47 ▂▄__ WPA2 802.1X

xx:xx:xx:xx:xx:xx Livebox-xxxx Infra xx xxx Mbit/s 40 ▂▄__ WPA1 WPA2

xx:xx:xx:xx:xx:xx WiFiExtender-xxxxxxxxxxxx Infra xx xxx Mbit/s 34 ▂▄__ WPA2

xx:xx:xx:xx:xx:xx Freebox-xxxxxx Infra xx xxx Mbit/s 34 ▂▄__ WPA2

xx:xx:xx:xx:xx:xx Wifisalonxx Infra xx xxx Mbit/s 32 ▂▄__ WPA2

xx:xx:xx:xx:xx:xx SFR_xxxx Infra xx xxx Mbit/s 29 ▂___ WPA1 WPA2

xx:xx:xx:xx:xx:xx FreeWifi_secure Infra xx xxx Mbit/s 29 ▂___ WPA2 802.1X

xx:xx:xx:xx:xx:xx SFR-xxxx Infra xx xxx Mbit/s 24 ▂___ WPA1 WPA2

xx:xx:xx:xx:xx:xx freebox_chats Infra xx xxx Mbit/s 24 ▂___ WPA2

Rafraichir cette liste avec :

nmcli device wifi rescan

Pour vous connecter à un réseau sans fil "classique" :

nmcli device wifi connect <SSID> --ask

Pour se connecter/déconnecter à un réseau déjà connu :

nmcli connection up/down <SSID>

nm-connection-editor

nm-connection-editor est un gestionnaire graphique des réseaux. Il vous permettra de gérer les connexions réseaux de manière graphique.

sudo pacman -S nm-connection-editor

Gestionnaire de paquets

Le gestionnaire de paquets de base d'Archlinux est pacman. Il s'agit d'un bon gestionnaire de paquets mais il n'utilise pas l'AUR (Arch User Repository). Il s'agit du répertoire des paquets créés par la communauté.

Tout d'abord, pensez à mettre à jour vos bases de données :

sudo pacman -Syu

ATTENTION, ce répertoire étant maintenu par la communauté, les paquets qu'il contient sont donc à utiliser avec précaution !

Yet Another Yogurt

yay est un gestionnaire de paquets utilisant l'AUR et est bien plus intéressant que pacman.

Pour l'installer :

sudo pacman -S base-devel \ # Paquets nécessaire pour compiler sous Arch

git

cd /tmp

git clone https://aur.archlinux.org/yay.git

cd yay && makepkg -si

YAY ne doit pas être installé en tant que root ! Le script d'installation refusera.

Shell

Arch Linux utilise par défaut le shell Bash (Bourne-Again SHell). Il s'agit du shell du GNU Project. Bien que ce shell soit fonctionnel et parfaitement utilisable, il en existe des plus agréables à utiliser.

Zsh